Cet article est le premier d’une nouvelle rubrique traitant des architectures complexes des sites et applications à fort trafic.

Tout le monde connaît Wikipedia, l’encyclopédie en ligne qui totalise près de 8 millions d’articles dans plus de 200 langues (15 langues ont plus de 100 000 articles). Tous les projets Wikipedia, Wiktionary, WikiBooks, WikiNews, etc., sont soutenus et hébergés par la fondation Wikimedia.

Tout le monde connaît Wikipedia, l’encyclopédie en ligne qui totalise près de 8 millions d’articles dans plus de 200 langues (15 langues ont plus de 100 000 articles). Tous les projets Wikipedia, Wiktionary, WikiBooks, WikiNews, etc., sont soutenus et hébergés par la fondation Wikimedia.

Commençons par quelques chiffres sur cette plate-forme pour situer le contexte :

- Wikipedia est le 9ème site le plus plus consulté au monde selon Alexa,

- plus de 350 serveurs répartis dans 3 datacenters différents (Floride, Amsterdam, Séoul),

- près de 50 000 requêtes HTTP/seconde en pic, pour une moyenne de 27 000 requêtes HTTP/seconde,

- 2,2 Gbits/s de bande passante moyenne pour 3,7 Gbits/s en pic,

- en moyenne, 2 000 nouveaux articles et 200 000 edits quotidiens,

- 1,3 To de stockage pour les images (plus de 4 millions de fichiers),

- 25 Go de données dans MySQL,

- un nombre de mots avoisinant les 2,5 milliards,

- une croissance exponentielle : doublant tous les six mois en terme de visiteurs/trafic/serveurs.

Dans le second article de ce dossier, je détaillerai l’architecture, la répartition de l’effort informatique, ainsi que les astuces utilisées par Wikimedia pour garantir un service de qualité avec peu de serveurs.

Sources :

Tout le monde connaît

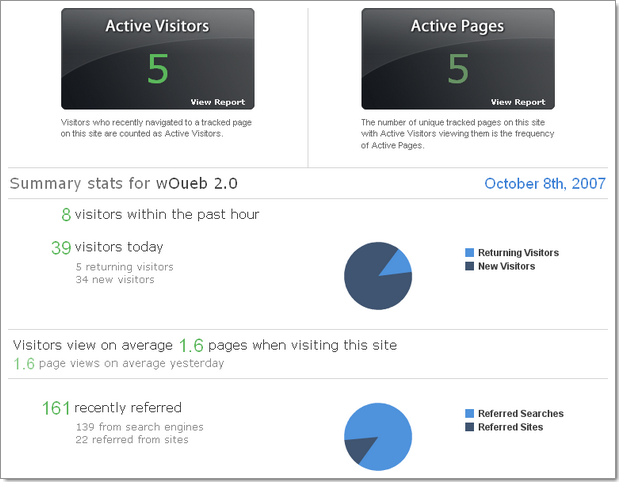

Tout le monde connaît  Dans la longue liste des outils de statistiques, je me suis penché sur

Dans la longue liste des outils de statistiques, je me suis penché sur